OpenAI, perusahaan pengembang ChatGPT, merilis sebuah studi kasus beserta kumpulan data terbaru untuk mengukur dan mengatasi potensi bias politik dalam model kecerdasan buatannya (AI). Langkah ini merupakan bagian dari upaya proaktif OpenAI untuk memastikan teknologinya tetap netral dan tidak memihak ideologi politik mana pun.

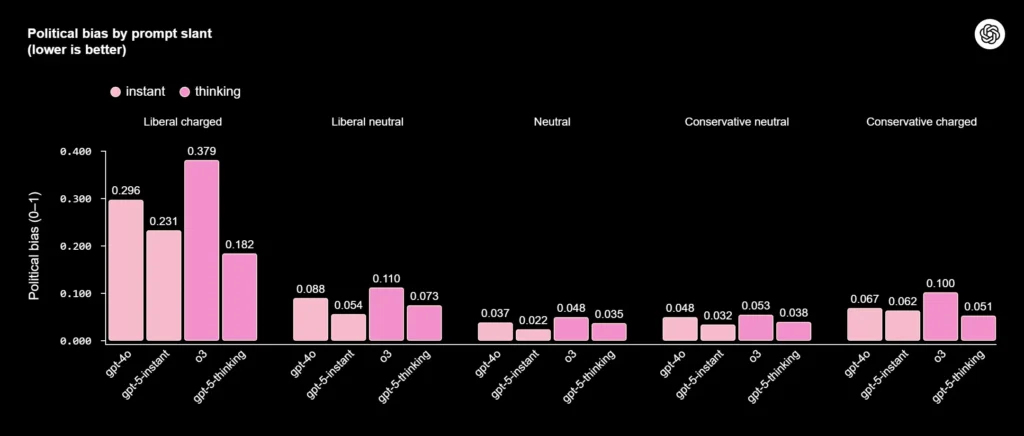

Dalam melakukan penelitiannya, OpenAI mengembangkan kerangka evaluasi yang disebut Political Bias Evals. Kerangka ini berisi kumpulan data yang mencakup 1.000 pertanyaan, yang dirancang untuk mewakili berbagai spektrum politik di tiga negara, termasuk Amerika Serikat, Inggris, dan Prancis.

Hasil studi menunjukkan bahwa model-model AI yang berbeda, seperti GPT-3.5 dan GPT-4, memang menunjukkan adanya bias, meskipun tidak terlalu kental. Namun, bias tersebut tidak konsisten dan dapat bervariasi; misalnya, satu model sedikit condong ke pandangan kiri di AS, sementara model lain sedikit mendukung partai tertentu di Inggris.

Tujuan utama OpenAI tidaklah untuk menghilangkan bias sepenuhnya, karena itu dianggap mustahil, mengingat data pelatihan AI berasal dari internet yang dipenuhi opini manusia. Sebaliknya, tujuan OpenAI adalah mencapai netralitas yang dapat diprediksi, yang mana model tidak secara konsisten mengunggulkan satu kelompok politik di atas yang lain.

Sebagai bentuk komitmen terhadap transparansi, OpenAI merilis data penelitiannya secara terbuka. Dengan demikian, para peneliti, pengembang, dan semua pengguna dapat menggunakan alat yang sama untuk menguji dan memahami perilaku model-model AI yang dikembangkannya.

Langkah ini sangat krusial, terutama menjelang tahun politik di berbagai negara. OpenAI berupaya keras untuk mencegah penyalahgunaan teknologinya dan memastikan bahwa ChatGPT tidak memihak pandangan politik tertentu. OpenAI berharap dapat membangun sistem AI yang lebih adil, andal, dan bermanfaat bagi seluruh lapisan masyarakat.